基于Android平台的可视对讲系统设计

出处:wkq0821 发布于:2013-01-22 16:06:16

Android是Google公司推出的基于Linux的开源手机操作系统,由于代码开源,受到很多手机厂家的青睐。可视对讲系统在Android操作系统未出现之前,软件研发一般采用底层语言,容易出现功能单一、产品升级困难等情况,要在对讲系统中开发出具有3D图形效果的界面更是难上加难。鉴于此,本文利用Android平台的可移植性、代码开源等优势,结合JNI、NDK技术,提出了基于Android平台的可视对讲系统的设计方案并加以实现。

JNI[1](Java Native Interface)是Java本地调用接口,它使得运行于Android平台的Java程序可以使用C、C++甚至汇编语言编写的动态链接库。在需要频繁访问内存或复杂计算的情况下,使用C动态链接库比在Android平台上使用Java语言实现相同功能更具有效率[2].NDK[3](Native Development Kit)提供了一系列的工具,可以生成ARM二进制码的动态库,并且能自动地将生成的动态库和Java应用程序一起打包成Android系统可以直接安装的apk安装包,即NDK可以将包含JNI接口函数的C源程序文件编译生成动态库,供Android应用程序调用,提高了对现有代码的重用性,而加快了开发进度。

本文提出一种可视对讲系统设计方案,对讲双方为门口机和室内机,并将设计方案在i.MX51硬件平台进行实现。门口机进行音视频的采集、编码、传输及音频解码、播放;室内机采用Android平台,但考虑用户室内信息的保密性,室内机没有视频采集功能,室内机只进行音视频的解码、播放以及音频的采集、编码、传输。

1 可视对讲系统设计

1.1 通信流程设计

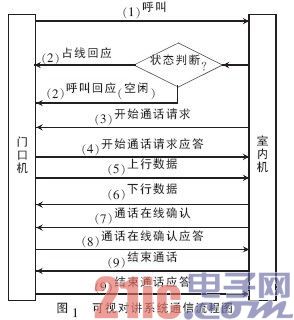

数据包传输协议使用面向无连接、资源消耗小、处理速度快的UDP协议。寻址完成建立UDP直连后,门口机首先对视频进行编码传输,直到被叫方按下接听键后,门口机才对音频数据进行传输。为了保证通话一直在线,室内机每隔一定的时间向门口机发送通话在线询问,如果收到在线确认应答则保持通话状态,否则就结束通话。可视对讲系统通信流程如图1所示。

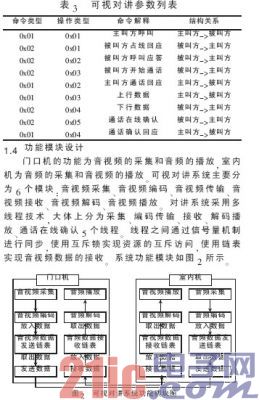

表2中:包头为对讲数据包的标示符,命令类型、操作类型说明详见表3,时间戳主要是用于音视频的同步,数据类型分为音频和视频两种,帧序号为0~65 535.如果没有进行数据包分段,则总包数与当前包数均为1.音视频数据从第41位开始算起,音视频数据长度由数据包格式中的数据长度所指定。

根据系统通信流程图1、结合数据包格式,本对讲系统参数如表3所示。其中命令类型、操作类型分别与表2数据包格式相对应。

1.5 音视频编解码选择

系统音频编码选用G.711编码[4].G.711是一种由国际电信联盟订定的音频编解码方式,拥有一倍的压缩率,是语音通信中常用的编解码方式之一。采样和量化是音频编程及声音数字化的两个关键步骤,本系统使用的音频采样频率为8 kHz、量化位数为16 bit、单声道。

FFmpeg是用于音频和视频开源方案,由于它的开源和以及跨平台的特点,受到开发商的青睐。FFmpeg支持包括xvid等在内的多达90种解码器,由C语言实现,不仅可以应用于PC软件平台,也可以用于嵌入式设备。本系统中视频选用xvid编解码器,视频格式为MPEG-4.(xvid是一个开放源代码的MPEG-4视频编解码器)视频标准采用NTSC制,视频尺寸为352×240,帧频为30 F/s;使用NDK提供的交叉编译工具将包含JNI接口函数的音视频编解码源文件统一编译成为动态链接库,供Android平台调用。

2 系统实现

2.1 系统软硬件平台

系统硬件平台为i.MX51 EVK.i.MX51 EVK是由Freescale公司自主研发的,中央处理器基于ARM Cortex A8的i.MX51处理器;主频可扩展到1 GHz;处理器内部集成了DDR/DDR2内存控制器、OpenGL/OpenVG图形、ATA控制器、以太网控制器等,支持720 p高清视频播放;指令缓存和数据缓存为32 KB,二级缓存为256 KB;其容量指标是之前ARM11产品的2倍,可大大提高CPU的处理能力。同时处理器内部还集成了矢量运算的浮点运算及信号处理加速器,为多媒体信息娱乐终端提供了强大的处理支持[5].

系统软件平台采用Linux操作系统、eclipse集成开发环境。Android SDK[6]版本为2.2,Android NDK版本为android-ndk-r6.使用串口进行调试。

2.2 Android平台在i.MX51 EVK上的移植

系统采用4 GB的SD卡存放引导程序、内核、根文件系统等镜像。引导程序采用U-Boot,Linux内核版本为2.6.31.移植流程:Android源码可以从https://source.android.com获取到,编译好U-Boot、Linux内核、根文件系统以及Android系统镜像[7]后,设置i.MX51板上的S1 Boot Switch模式为1100000001,使用ATK工具进行镜像的。后系统镜像在SD卡上分布图如图3所示。

图3中,MBR主要存储SD卡的分区信息表,起始地址为0 KB.引导程序、内核、根文件系统的起始地址分别为1 KB、1 MB、4 MB.System和Recovery分别各占一个分区,System为Android操作系统的镜像文件所占分区,Recovery分区主要是用来备份和还原系统。

2.3 音视频编解码实现

2.3.1 音频编解码实现

音频编码与解码的区别仅在于调用的C库函数不一样,音频编解码调用的C库函数分别为G711Encoder、G711Decoder(本文以解码为例)。音频解码具体流程如下:

(1)音频Java本地调用函数

在使用音频解码的类中编写Java本地调用函数:

public native void G711Decoder(byte[]pcm,byte[]code,int size,int lawflag);

(2)生成头文件

C库与Java间需要一个后缀为“.h”的头文件来衔接,这个头文件通过javah命令生成,javah工具包含在JDK中。JDK是Java的,包含Java运行环境、Java工具、Java基础类库

(3)JNI接口函数

JNI接口函数编写在C语言文件中,与音视频解码源码一起打包生成动态链接库。在接口函数中声明4个无符号指针变量:decode指向待解码的数据、depcm指向解码后的数据、enpcm指向待编码的数据、encode指向编码后的数据。解码代码如下:

void Java_com_qsa_play_G711Decoder

(JNIEnv*env,jobject this,jbyteArray pcm,jbyteArray code,jint size,jint lawflag)

{

depcm=(unsigned char*)(*env)->

GetByteArrayElements(env,pcm,0);

decode=(unsigned char*)(*env)->

GetByteArrayElements(env,code,0);

G711Decoder(depcm,decode,size,lawflag);

(*env)->ReleaseByteArrayElements(env, pcm,

(jbyte)depcm,0);

(*env)->ReleaseByteArrayElements(env,code,(jbyte)

decode,0);

}

其中,depcm=(unsigned char*)(*env)->GetByteArrayElements(env,pcm,0)用来获取Java层传递的待解码字节数组的首地址,G711Decoder()函数实现音频解码,(*env)->ReleaseByteArrayElements(env,pcm, (jbyte)depcm,0)释放传递的数组成员,进行资源回收。

(4)使用NDK中ndk-build命令编译生成动态链接库

ndk-build命令是ndk命令工具集中的一个命令,与Linux下shell编程中的make命令相似,它会查找文件夹中的后缀为“.mk”的Makefile文件,根据该文件的依赖文件,将源文件编译成动态链接库。

2.3.2 视频编解码实现

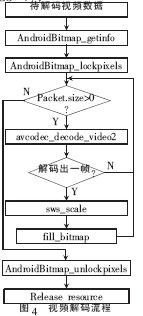

视频的编解码流程与音频编解码流程基本相似,视频编解码调用的C库函数分别为avcodec_encode_video、avcodec_decode_video2.限于篇幅,在此重点介绍Android平台视频的解码及显示。

在解码视频数据前,要先做一系列的准备工作:

(1)给出主要的数据结构

static AVPacket avpkt;

static AVFrame*picture;

static AVFrame*pFrameRGB;

static AVCodec*codec;

static AVCodecContext*c= NULL;

static struct SwsContext*img_convert_ctx;

AndroidBitmapInfo info;

void*pixels;

(2)初始化流程

①注册解码器

avcodec_init();

av_register_all();

②初始化AVPacket、AVCodecContext、AVFrame

av_init_packet(&avpkt);

c=avcodec_alloc_context();

picture=avcodec_alloc_frame();

其中,AVFrame是数据流在编解码过程中用来保存数据缓存的对象,从数据流中读取到的数据首先保存到AVPacket中。一个AVPacket多只包含一个AVFrame,而一个AVFrame可以包含好几个AVPacket.AVCodecContext用于动态记录一个解码器的上下文信息。

③设置视频解码器

codec=avcodec_find_decoder(MPEG-4);

avcodec_open(c,codec);

④视频解码流程

视频解码流程如图4所示。图4中,AndroidBitmap_getinfo用于获取Android平台Bitmap对象的大小,AndroidBitmap_ lockpixels函数是对Bitmap进行加锁、互斥使用资源。如果AVPacket包中存在未解码完的数据,则调用函数avcodec_decode_ video2进行解码;若解码出一帧后需要调用函数sws_scale进行格式转换。视频数据解码完后颜色空间为YUV,需转换成RGB颜色空间。调用fill_bitmap函数进行数据填充及进行Bitmap的解锁和资源的释放。

视频显示采用Android平台的ImageView控件进行显示。解码线程接收到视频数据后,通过JNI调用,调用动态库中的视频解码接口函数进行解码,每解码完一帧后通过消息通知主线程进行显示图像的更新,这样就达到了视频数据动态显示的效果。

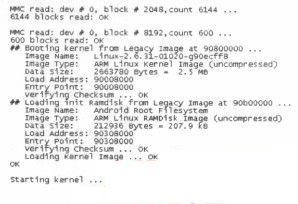

3 实现效果

Android平台在i.MX51 EVK平台上移植成功后,串口中Android 操作系统启动信息如图5所示。 从图中的启动信息可以看出,Android平台移植成功,启动信息也包含有CPU信息、内核版本、大小、加载地址、Android文件系统版本等信息。

该软件开发完成后,在Android工程的bin下生成apk文件,并复制apk文件到SD卡中,在Android系统中安装该软件,使用门口机进行拨号,编码后的音视频数据通过网线进行传输。

本文将Android手机操作系统应用于i.MX51 EVK平台,并在该平台上提出了可视对讲的设计方案,分别进行了通信流程、应用协议、功能模块等设计,实现了系统的设计方案。但由于视频是使用软件解码,运行效率有待提高,且语音对讲部分回声消除存在问题,有待进一步研究。

版权与免责声明

凡本网注明“出处:维库电子市场网”的所有作品,版权均属于维库电子市场网,转载请必须注明维库电子市场网,https://www.dzsc.com,违反者本网将追究相关法律责任。

本网转载并注明自其它出处的作品,目的在于传递更多信息,并不代表本网赞同其观点或证实其内容的真实性,不承担此类作品侵权行为的直接责任及连带责任。其他媒体、网站或个人从本网转载时,必须保留本网注明的作品出处,并自负版权等法律责任。

如涉及作品内容、版权等问题,请在作品发表之日起一周内与本网联系,否则视为放弃相关权利。

- 网桥是什么_网桥如何设置2024/4/12 17:39:56

- TEC 控制器在电信系统中的应用指南2024/4/8 17:43:07

- 什么是5G NR技术?2024/4/8 17:31:58

- OFDMA基本原理2024/4/7 17:45:04

- 一文读懂3GPP到底是什么2024/4/1 17:46:30